: 데이터 사이언스 팀을 위한 AI 슈퍼컴퓨팅

NVIDIA DGX Station A100

데이터 사이언스 팀을 위한 슈퍼컴퓨팅

- MIG 사용하여, 개인에게 28개 별도 GPU 할당 가능

어디에든 배치 가능한 AI 어플라이언스

- 표준 벽 콘센트와 전원을 연결, 최첨단 냉매 시스템 활용

더 커진 모델, 더 빨라진 응답

- MIG 지원 A100 GPUx4, 3세대 NVLink 활용 병렬 작업 실행

AI 시대를 위한 워크그룹 어플라이언스

NVIDIA DGX Station A100

사무실, 연구실 심지어 집에서 누리는

데이터센터의 성능

4개의 NVIDIA A100 Tensor 코어 GPU, 최첨단 서버급 CPU,

초고속 NVMe 스토리지, 첨단 PCIe Gen4와 함께 원격 관리 포함

- > 4 x NVIDIA A100 TENSOR CORE GPUs3세대 NVLink와 상호 연결되어 200GB/s 속도 제공

- > 7.68TB PCIe Gen4 NVMe SSDPCIe Gen3보다 2배 빠른 1.4M IOPS 스토리지 성능 제공

- > 최첨단 냉매 시스템최첨단 냉매 시스템을 활용하여 적은 소음의 연구 환경 제공

- > 64-core AMD CPU & PCIe Gen43.2배 더 많은 코어와 512GB의 시스템 메모리 제공

- > NVIDIA DGX Display Adapter4 x Mini DisplayPort, 4K 해상도 제공

- > 원격 관리 시스템통합 1Gbase-T 이더넷 BMC 포트 제공

- 2.5 PetaFLOPS

1세대 워크스테이션 보다

- 3배 빠른 성능

언박싱부터 연구 시작까지

- 3시간 이내

제품 작동에 필요한 것,

- 2 CABLES

- 0 Data Center

더 빨라진 Training & Inference, 더 좋아진 데이터 분석 능력

더없이 좋아진 AI 성능

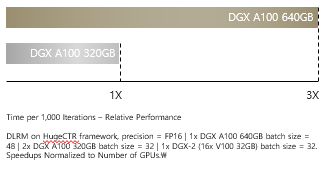

훈련

| DLRM 훈련- 대규모 모델에서 AI 교육을 위한 최대 3배 높은 처리량

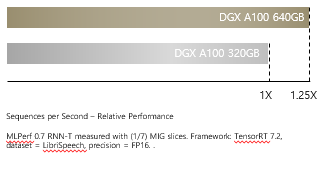

추론

| RNN-T 추론 : 단일 스트림- AI 추론을 위한

최대 1.25배 높은 처리량

- AI 추론을 위한

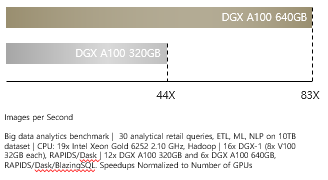

데이터 분석

| 빅데이터 분석 벤치마크- CPU 대비

최대 83배 높은 처리량

- CPU 대비

호환 가능 모듈

| NVIDIA DGX Station A100 320GB | NVIDIA DGX Station A100 160GB (EOL) | |

|---|---|---|

| GPUs | 4x NVIDIA A100 80 GB GPUs | 4x NVIDIA A100 40 GB GPUs |

| GPU Memory | 320 GB total | 160 GB total |

| Performance | 2.5 petaFLOPS AI 5 petaOPS INT8 | |

| System Power Usage | 1.5 kW at 100–120 Vac | |

| CPU | Single AMD 7742, 64 cores, 2.25 GHz (base)–3.4 GHz (max boost) | |

| System Memory | 512 GB DDR4 | |

| Networking | Dual-port 10Gbase-T Ethernet LAN Single-port 1Gbase-T Ethernet BMC management port | |

| Storage | OS: 1x 1.92TB NVME M.2 drive storage: 7.68 TB NVME U.2 drive | |

| DGX Display Adapter | 4x Mini DisplayPort | |

| System Acoustics | <37 dB | |

| Software | Ubuntu Linux OS | |

| System Weight | 91.0 lbs (43.1 kgs) | |

| Packaged System Weight | 127.7 lbs (57.93 kgs) | |

| System Dimensions | Height: 25.1 in (639 mm) Width: 10.1 in (256 mm) Length: 20.4 in (518 mm) | |

| Operating Temperature Range | 5–35 ºC (41–95 ºF) | |

MDSTECH-FLIR

MDSTECH-FLIR

열화상 블로그

열화상 블로그  열화상카메라 스토어

열화상카메라 스토어

NVIDIA AI 블로그

NVIDIA AI 블로그  네이버 톡톡 제품 문의

네이버 톡톡 제품 문의 MDS테크 AI 스토어

MDS테크 AI 스토어

윈도우와 IoT 이야기

윈도우와 IoT 이야기  IoT Tech Tube

IoT Tech Tube